Sandra González-Bailón: “Facebook ha dado una maquinaria de difusión a la derecha que no habría tenido de otro modo”

La profesora de la Universidad de Pensilvania ha liderado una investigación que revela el consumo de desinformación online por audiencias conservadoras

Un grupo de académicos publicó hace unos días cuatro artículos de una investigación sin precedentes con datos internos de Facebook e Instagram en EE UU. El texto más controvertido confirmaba que Facebook es una red dominada por audiencias conservadoras y que el 97% de la desinformación que circula es consumida por usuarios de derechas, prácticamente toda. La profesora que lidera este trabajo es la española Sandra González-Bailón, de la Escuela Annenberg de Comunicación de la Universidad de Pensilvania. En una conversación con EL PAÍS por videoconferencia explica los detalles y las implicaciones de su trabajo, que ha generado mucha atención y polémica.

Aunque la audiencia de Facebook para noticias políticas sea sobre todo conservadora, el origen de esa información está centrado en páginas y grupos. “En volumen hay muchos más usuarios que páginas o grupos. Pero si quitamos páginas y grupos, hay menos segregación. Tiene algo intuitivo porque no escoges a los miembros de tu familia, pero sí escoges qué páginas y grupos sigues. Hay más autoselección. Pero es una decisión del diseño de plataforma y de cómo se gobierna. Vemos que las páginas y grupos crean más división en lugar de ayudar a construir puentes. Igual que las ciudades están diseñadas para fomentar segregación o no, estas tecnologías también pueden diseñarse para reducir divisiones. Facebook no está diseñada para reducir las divisiones que ya preexistían. No las causa, pero podría reducirlas”.

1. ¿La izquierda no tiene desinformación?

“Quizá haya otro tipo de contenido (al margen de enlaces a noticias políticas) que apela más a las audiencias de izquierdas”, dice González-Bailón. “Tenemos puntos ciegos: qué hubiera sucedido si analizamos memes políticos en lugar de enlaces. Hay mucho otro contenido político que también difunde desinformación y que a lo mejor está en la izquierda. El artículo se refiere a noticias que siguen ciertos parámetros periodísticos”, añade.

Lo único que se sabe claramente es que la izquierda no ha creado en Facebook docenas de páginas que se dedican a difundir información dudosa o partidista: “Hay una asimetría de la forma de activismo informativo y político entre la derecha y la izquierda”.

Ocurre lo mismo con el extremismo. Las audiencias en Facebook tienen tres grandes grupos: dos simétricos y moderados a derecha e izquierda y otro extremo a la derecha. ¿Por qué ese no tiene su equivalente a la izquierda? “Las audiencias que en promedio son conservadoras están divididas. Hay un extremo muy claro, pero también vemos que hay un grupo moderado. No significa que no haya extremismos en la izquierda, pero se manifiestan de otra manera”, explica.

2. La derecha explota el algoritmo

Junto al consumo de desinformación, la otra gran confirmación de su artículo publicado en Science es la derechización de la audiencia de Facebook. Primero hay que entender cómo funciona el algoritmo de Facebook. El artículo estudia tres cosas: uno, el inventario de todos los posts que Facebook puede enseñarnos; dos, los que realmente ven los usuarios; y tres, los que nos llevan a interactuar.

“Las páginas y grupos crean más división en lugar de ayudar a construir puentes”

Pero en las redes, el contenido político es solo una parte más bien pequeña de todo lo que se ve. ¿Hay otros tipos de contenido que te llevan en una dirección política u otra? “Los algoritmos no solo aprenden de tus interacciones con noticias políticas, aprenden de un montón de cosas más. El bucle no es perfecto en este caso porque nosotros solo analizamos interacciones con noticias políticas. Ese bucle es muy difícil de desvincular con este tipo de datos que tenemos”, advierte.

¿Cómo puede explotar este montaje algorítmico y humano un activista conservador? Un camino obvio es provocar para que los usuarios de derechas den más señales de qué les gusta, que cliquen más. Ese contenido no tiene por qué ser solo estrictamente político: “Si las audiencias conservadoras reaccionan más al contenido que ven, esto refuerza de forma asimétrica el mecanismo de retroalimentación positiva: si los liberales no clican me gusta tanto como los conservadores, el algoritmo los llevará por otro camino y, en general, el contenido político conservador flotará a mayores niveles de visibilidad”, explica.

La investigadora desarrolla esta hipótesis de una vía para explotar el algoritmo: “Los medios de sesgo conservador más radical usan clickbait [reclamos exagerados para que la audiencia pinche] para generar más reacciones. Y, por tanto, más señales que indican al algoritmo que ese contenido genera interés, así que el algoritmo lo promueve más, creando asimetrías en el proceso”. Es como si en un bazar vendiera más quien más grita: no solo lograría más ventas, sino que los clientes atraerían a más clientes.

Tiene una segunda hipótesis: “Las páginas y grupos permiten coordinar redes de información: por ejemplo, páginas y grupos pueden ser administradas por actores que actúan al unísono, plantando las mismas semillas en varias partes de la red al mismo tiempo. Esta es una forma de manipulación no muy distinta a la propaganda y la podemos considerar como una forma de activismo”, aclara González-Bailón.

3. Queda desinformación por desenterrar

La investigación se centra solo en publicaciones de Facebook con enlaces a noticias políticas. Pero el universo de Facebook es mucho mayor: hay memes políticos, hay comentarios sin enlaces y también hay noticias presuntamente falsas que los fact-checkers que trabajan con Facebook no han identificado.

“Hay un montón de contenido que no se evalúa”, resume. Así, aunque solo el 3% de todo el contenido que analizaron sea etiquetado como falso, es probable que haya más. “Los criterios, según Facebook, que se siguen a la hora de determinar si algo es verdad o falso es muy basado en hechos, pero nosotros hemos encontrado ejemplos de noticias sin hechos falsos pero presentadas de una manera potencialmente manipuladora. Esas noticias no reciben la calificación de falsas porque no lo son, pero mucha gente no hace ni clic en el link para leer la historia, solo ven el titular”, añade.

Una acusación repetida sobre el proceso de verificación es que esas organizaciones tienen un sesgo de izquierdas: “Nos lo han preguntado varias veces. Solo puedo especular, no tenemos datos”, reconoce la especialista. Pero sí han encontrado un sesgo sobre qué tipo de noticias son analizadas por los verificadores: la viralidad. “Es más probable que se evalúe una noticia que ha sido compartida muchas veces. Si algo tiene tracción, es más probable que se evalúe. Así que la desinformación analizada solo es la punta del iceberg”, añade.

4. ¿Existiría esta audiencia sin Facebook?

Facebook no surgió de la nada. González-Bailón destaca la última frase de su artículo, donde recalcan que la polarización ya existía: “Estos patrones son parte de un conjunto más amplio de cambios asociados con la fractura del ecosistema de noticias, que van desde Fox News hasta los programas de radio, pero también son una manifestación de cómo las páginas y los grupos brindan una maquinaria muy poderosa de curación y difusión que es usada con especial eficacia por fuentes con audiencias predominantemente conservadoras”.

“Facebook contribuye a dar mucha más visibilidad a dominios que son, fuera de la plataforma, periféricos”

Facebook no creó nada, pero los conservadores lo han usado como una plataforma donde su activismo funciona mejor: “No podemos ir a la raíz del porqué”. “Pero hay una maquinaria de difusión de información intencional y estas fuentes de noticias emplean páginas y grupos de forma muy eficiente. Es una forma de activismo conservador. La derecha tiene en EE UU, no sé si en España sucede lo mismo, una maquinaria. Facebook ha dado a esa maquinaria una difusión que no habría tenido de otra manera”.

5. Sofisticado y coordinado

Facebook nació para estar al día de la actividad de tus amigos. Quizá una parte de la red sigue siendo así, pero el consumo de información política se ha sofisticado y coordinado extraordinariamente. Sobre todo por dos herramientas: las páginas y los grupos.

“No podemos verificarlo con los datos que tenemos, pero es probable que haya ciertas redes de coordinación que provocan estos efectos de ondas expansivas”, explica la profesora de la Universidad de Pensilvania. “Hay características de esta plataforma que lo favorecen, sobre todo las páginas y grupos. Las páginas tienen un alcance mayor que los grupos. Las páginas son medios de difusión. Cuando surgieron las redes se hablaba mucho del peer to peer [entre iguales]. Pero las páginas emiten a millones de seguidores. Los grupos, por su parte, permiten coordinarse. ¿Hay coordinación entre las páginas del extremo más conservador y grupos? No lo sé, pero puede ser uno de los mecanismos que explique la asimetría con la izquierda”.

6. La esquina de la desinformación

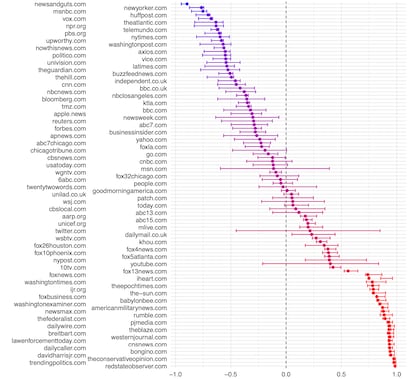

El apéndice del artículo esconde uno de los gráficos más ilustrativos del trabajo. Los investigadores han analizado los 100 medios principales según su audiencia. La clasificación es lo esperado: hay más interés en la izquierda por el New Yorker, el New York Times o el Washington Post y en la derecha por el Wall Street Journal, el Daily Mail o el New York Post. Pero luego hay una esquina con unos 25 dominios que viven en su mundo ultraconservador, como American Military News, Pajamas Media o The Conservative Opinion: son la esquina de la desinformación.

“Este gráfico querría haberlo puesto en el paper principal”, afirma. “Ilustra dos cosas. Una es que hay dominios o fuentes de noticias que son muy versátiles en función de las audiencias que activan: publican artículos que llaman mucho la atención a audiencias liberales y conservadoras. Pero llama aún más la atención las fuentes en la parte inferior derecha. Esta es la esquina donde se encuentran la mayor parte de noticias que se han etiquetado como desinformación”.

7. ¿Crea Facebook medios conservadores?

“La gente que está expuesta a esta esquina [de desinformación de derechas] y a nada más, es posible que sean más vulnerables a estas fuentes. Pero en la medida en que estas audiencias no participan en experimentos como los nuestros, tampoco sabemos qué pasa con ellos”, advierte.

“Necesitaríamos un mundo paralelo sin Facebook para poder determinar qué sería de estos dominios sin la plataforma”

Dicho esto, el consumo en internet y en Facebook de información política es distinto. Los ciudadanos que van a la web a buscar información tienen un sesgo de izquierdas. En Facebook es justo al contrario: “Las redes abren un ecosistema informativo que permite que ciertas fuentes alcancen mucha más visibilidad de la que tendrían de otra manera. ¿Cuál es la diferencia? En la web no vas a una de estas páginas si no quieres ir. En las redes, en cambio, hay mucha exposición no intencional a estas noticias”, desarrolla la investigadora.

La pregunta difícil sobre esto es qué hubiera ocurrido si Mark Zuckerberg no hubiera creado Facebook con todos esos medios. ¿Existirían igual en otro entorno? “Necesitaríamos un mundo paralelo sin Facebook para poder determinar qué sería de estos dominios sin la plataforma”.

La única aproximación es comparar esos medios con la web abierta. Habrían tenido una vida mucho más compleja: “En Facebook, Dailywire tiene más o menos el mismo número de visualizaciones que la CNN. Si usamos datos de Comscore, una compañía de medición de audiencias en la web, Dailywire tiene un alcance del 4%, es decir, que el 4% de la población online va a su página, mientras que el de CNN es 60%. Es un hecho que Facebook contribuye a dar mucha más visibilidad a dominios que son, fuera de la plataforma, periféricos”.

8. Es caro y difícil, pero debe hacerse

Hay al menos dos problemas para seguir haciendo estos estudios: que las redes sociales cedan sus datos y que los académicos tengan recursos. “Hemos trabajado superduro no solo para publicar estos resultados que abogan por la visión de que tiene valor hacer estas colaboraciones. Pero también hemos demostrado que se puede garantizar la transparencia y la independencia en la medida de lo posible. No se pueden hacer estos experimentos con estas plataformas sin su colaboración. Dadas estas constricciones y los equilibrios que hay que hacer para proteger la privacidad de los usuarios, es un ejemplo de qué se puede hacer en otros países”, explica González-Bailón.

El nuevo Reglamento de Servicios Digitales de la Unión Europea puede ayudar a que las tecnológicas abran algo sus cajas negras: “Esperamos que la UE legisle en favor de esto. Es una cuestión que está más allá de nuestro alcance. Hemos hecho lo que nos toca: demostrar que es posible”.

Hay otro detalle crucial sobre estas investigaciones. Requieren dinero y una gran capacidad computacional: “Esto cuesta mucho dinero. Es algo que los legisladores también deben saber. Esto no es una tabla de Excel que te puedes bajar a tu ordenador. La mayoría de universidades no tienen la capacidad computacional para procesar estos datos. Meta puso mucho dinero, no en forma de salarios, sino en forma de servidores, horas de trabajo. O invertimos en infraestructuras públicas o no podremos hacerlo. El acceso a datos es una parte del problema. El otro es la infraestructura”.

El futuro es TikTok

Los investigadores que han realizado este conjunto de estudios con Meta confían en que sus trabajos, y los 12 que aún quedan por publicar, sean solo una primera etapa. Pero el futuro debería traer nuevas investigaciones: TikTok, cuyo algoritmo es una evolución de las redes originales, plantea problemas nuevos.

“TikTok ha supuesto una desviación de cómo pensamos sobre las redes. Cuando surgieron las redes, el énfasis era el grafo social [árbol de relaciones] porque era una forma de curar información. Lo que estas plataformas hicieron es capitalizar la información de esas redes: si todos mis amigos lo comparten, a mí me va a gustar. TikTok es otra generación. Ahora la inteligencia artificial es más potente y no necesita el grafo social. Ahora se depende de predicciones automatizadas basándose en tu comportamiento, no con quién estás conectado. El algoritmo es todavía más potente porque ha eliminado al individuo contextualizado en su red”, advierte Sandra González-Bailón.

Puedes seguir a EL PAÍS Tecnología en Facebook y Twitter o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.

Sobre la firma